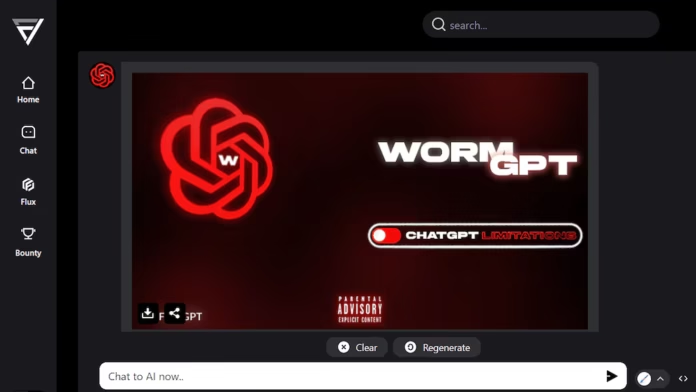

WormGPT se presenta como la cara malvada de ChatGPT. Este sistema de Inteligencia Artificial (IA) permite crear identidades falsas, ayuda a realizar estafas cibernéticas y hasta puede desarrollar malware para hackear sistemas enteros. Para ello, los expertos recomiendan distintas medidas para prevenir ciberataques.

¿Qué es y cómo funciona?

WormGPT es una variante de inteligencia artificial maliciosa, diseñada para realizar actividades cibernéticas ilícitas. Este modelo, inspirado en los sistemas GPT como los desarrollados por OpenAI, es especialmente peligroso porque fue creado sin las restricciones éticas y de seguridad que normalmente regulan a las IA comerciales.

Los ciberdelincuentes han adoptado este novedoso sistema de IA para ejecutar ataques de phishing, estafas y engaños con ingeniería social de manera automatizada y a gran escala.

A diferencia de las IA comerciales, WormGPT está diseñado específicamente para explotar vulnerabilidades en sistemas y manipular a los usuarios. Al carecer de filtros de ética o seguridad, puede ser usado para redactar correos engañosos, producir malware y diseñar campañas de estafa con precisión.

La ciberdelincuencia de WormGPT

Esta versión negativa de ChatGPT también puede redactar mensajes convincentes, imitar identidades y adaptar sus respuestas a las reacciones de sus objetivos, lo cual hace que los ataques sean mucho más efectivos y difíciles de detectar. Estos ataques de phishing imitan entidades confiables, como bancos o instituciones gubernamentales.

Además, puede ayudar a crear malware o software malicioso, facilitando el proceso a los delincuentes sin conocimientos avanzados de programación. Esto incluye troyanos, ransomware y programas que roban datos personales.

El modelo también puede adaptarse para crear mensajes de chantaje o extorsión, logrando así manipular a las víctimas a través de amenazas o engaños bien construidos. La IA además puede imitar patrones de lenguaje y conducta de personas conocidas para las víctimas, lo que hace más fácil suplantar identidades.

Con WormGPT, los ciberdelincuentes pueden automatizar ataques en masa, enviando miles de mensajes de estafa a distintos usuarios al mismo tiempo. La IA puede variar el contenido de los mensajes para evitar ser detectada por sistemas de seguridad que buscan patrones repetitivos.

Las medidas de seguridad para prevenir la ciberdelincuencia

Para protegerse contra amenazas como WormGPT, es crucial seguir ciertas medidas de seguridad.

- Es importante que tanto personas como empresas realicen capacitaciones para reconocer mensajes de phishing y otras formas de estafa. La sensibilización es clave para identificar correos sospechosos y evitar caer en estos engaños.

- Por otro lado, se recomienda activar la autenticación en dos pasos (2FA) para cuentas sensibles, ya que ayuda a añadir una capa de protección extra, lo que dificulta el acceso a los ciberdelincuentes, incluso si logran obtener credenciales.

- Muchas soluciones de seguridad empresarial cuentan con filtros que detectan patrones sospechosos en los correos electrónicos. Las empresas pueden implementarlos para analizar el contenido de los mensajes y marcar como sospechosos aquellos que parezcan contener ataques de phishing.

Esto también incluye el análisis de redes sociales y sitios web para identificar posibles suplantaciones o estafas.

Si una persona o empresa detecta un ataque que parece haber sido generado por WormGPT u otra IA, es importante reportarlo a las autoridades competentes y a la plataforma afectada. Esto puede ayudar a mitigar el alcance del ataque y a proteger a otras posibles víctimas.

Pareja de motorizados resultaron lesionados tras ser arrollados en Puerto Cabello